部署Dify知识库对接DeepSeek本地大模型

Dify 是一个用于构建 AI 应用程序的开源平台。我们将后端即服务和 LLMOps 相结合,以简化生成式 AI 解决方案的开发,让开发人员和非技术创新者都可以使用它。

用自己的知识库训练数据结合AI大模型产出更为贴合业务的成果,

在服务器上部署Dify知识库

docker网络架构问题,Dify建议服务器上搞方便。我用的莱卡云香港CN2GIA的云服务器搭建的,优惠地址如下:

https://www.lcayun.com/aff/ZEXUQBIM

手动部署,部署后在80端口访问这是官方默认的,可以自己进入.env修改暴露端口。

mkdir -p /home/docker/

cd /home/docker/

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker compose up -d

自动部署,不喜欢手动部署可以用kejilion脚本进行自动化部署,我已经集成到脚本里面了。会暴露在8058端口上,适合后期反向代理成域名使用。

科技lion脚本获取地址:https://kejilion.sh

搭建好,进入网页设置初始管理员邮箱密码。先放着我们先装本地大模型。

在本地安装deepseek

先把deepseek装好看这篇文章,为啥deepseek在本地部署,因为本地算力比服务器强多了,有N卡更适合。

Ollama本机跑默认只能本机访问,内网穿透直接403了。我找了很多资料最后发现要调整变量重启电脑,这样就可以内网被访问或者通过内网穿透暴露在外网,供dify使用。

在Windows中CMD终端输入如下命令重启电脑。

setx OLLAMA_HOST "0.0.0.0:11434"

除了安装deepseek-r1大模型还要嵌入式文本向量大模型,同样是通过Ollama进行安装。

ollama pull nomic-embed-text

deepseek内网穿透到公网

将本地的11434暴露到公网的任意可用的端口,内网穿透方法,看视频。

b站视频

https://www.bilibili.com/video/BV1yMw6e2EwL?t=0.1

图文教学

之前分享的全部用上了,知识的完美整合。

Dify对接deepseek

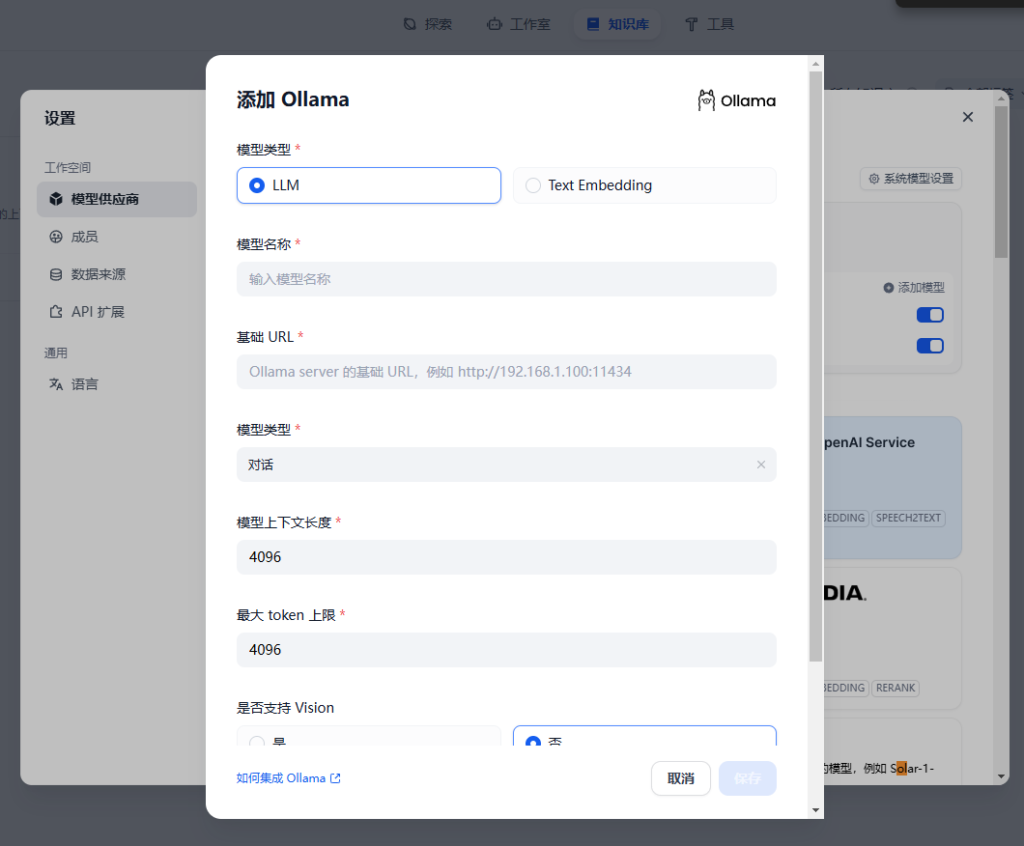

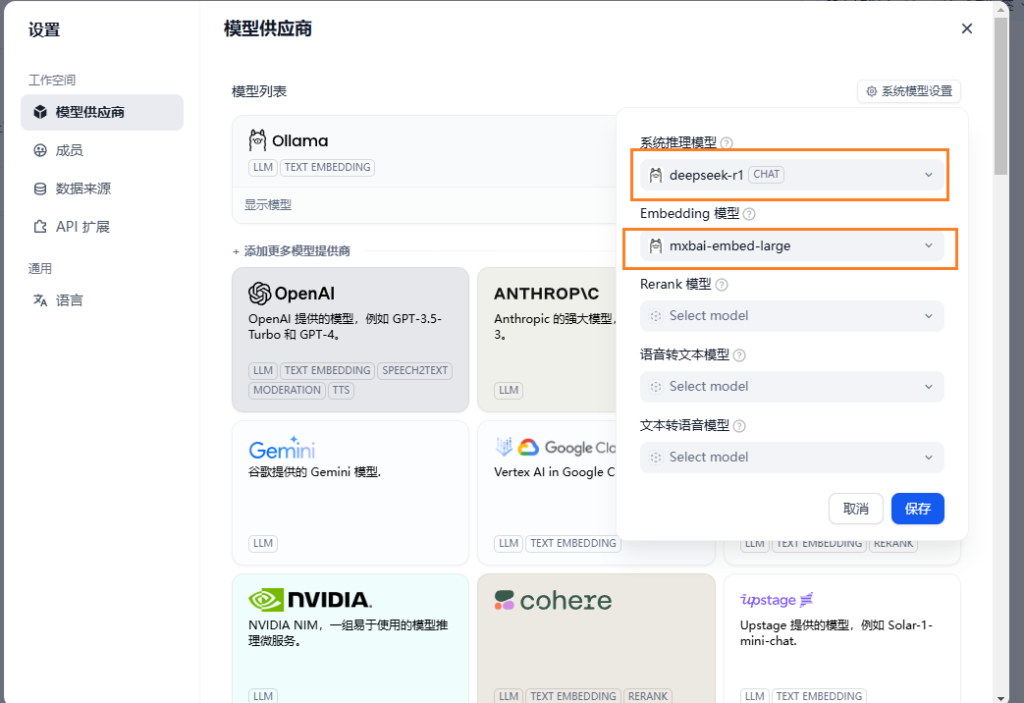

回到Dify网页到设置里添加模型,先对接deepseek-r1大模型再对接Embedding 模型。

版权声明:

作者:KEJILION

链接:https://blog.kejilion.pro/dify-deepseek-r1/

来源:科技lion官方博客【国内版】

文章版权归作者所有,未经允许请勿转载。

hzzhy

一键部署安装不了呢?

Kyle

我的甲骨文云一键部署,开不开网页

KEJILION@Kyle

防火墙检查

tangdouba

甲骨文AMD小鸡,安装之后IP+端口和做了反代都无法链接呢?我进docker也看不到,只能在11-58里面看到安装了。

KEJILION@tangdouba

机器什么配置 是不是太弱了

kejilion

启动需要时间的 机器弱的会很慢或者安装直接炸